ごきげんよう。

「ゼロからのAIフロンティア」へようこそ。

当ブログ運営しているケンタロウです。

最近、画像生成AIの中でも特に話題の

「Stable Diffusion」

を使いこなそうとする中級者が増えています。

でも、こんな疑問、ありませんか?

- 「プロンプトを工夫しても、なんだか思い通りの画像が出ない…」

- 「設定が多すぎて、どこをいじればいいのか分からない…」

- 「初心者向けの記事ばかりで、中級者の自分には物足りない」

そんなあなたに向けて、今回はStable Diffusionをもっと自由に操るための“中級者向け3つの活用法”をお届けします。

この記事を読むことで、一歩先を行く画像生成スキルが身につくだけでなく、他のユーザーと差をつける表現力も磨かれます。

設定の最適化やプロンプトの応用術、さらには拡張ツールとの連携方法まで、実践的なポイントを厳選してご紹介しますので、最後までぜひお付き合いください!

Stable Diffusionとは?中級者が押さえておきたい基本の再確認

初心者向けとの違いは?中級者が注目すべき視点

Stable Diffusionは、高品質な画像を生成できることで知られていますが、そのポテンシャルを最大限に引き出すには、初歩的な操作だけでは不十分です。

初心者向けの使い方では、基本的なプロンプト入力やサンプルモデルの使用が中心ですが、中級者はそれ以上のステップが求められます。

たとえば、構図の意識や解像度設定の理解、さらには画像ごとの出力傾向を読み解く力が問われます。

また、初心者の多くはエラーが出ないように無難な設定を選びがちですが、中級者は失敗も想定しながら新たな組み合わせや数値設定を試行錯誤する姿勢が求められます。

つまり、中級者にとって重要なのは

「安定して生成できること」

ではなく

「目的に応じた最適解を引き出せる技術」

なのです。

Stable Diffusionの進化と最新トレンド

Stable Diffusionは、登場当初から注目を集めてきましたが、現在ではバージョンアップや関連ツールの拡張によって、表現の幅が大きく広がっています。

特に注目すべきなのが、ControlNetやLoRAなどの周辺機能。

これらを用いることで、単なるテキスト生成から、ポーズ・構図・スタイルまで細かく調整できる時代になりました。

こうした技術の進化により、これまで難しかった

「思い通りの画像生成」

も徐々に実現可能になってきています。

また、Stable Diffusionコミュニティでは日々、新しいプロンプトテンプレートやTipsがシェアされており、それらを上手に活用することで中級者でも確実にステップアップが図れます。

つまり、ツールの理解と時流の把握が、Stable Diffusionを使いこなすカギだといえるでしょう。

モデル・設定・出力の関係性を理解する

画像生成の質を大きく左右するのが

「使用するモデル」

「設定値」

「出力解釈」

の3点です。

まず、Stable Diffusionはベースモデルの選択が非常に重要です。

一般的なSD1.5系から、表現力豊かなSDXL系までさまざまですが、モデルによって得意な絵柄や雰囲気がまったく異なります。

たとえば、リアルな人物を描きたい場合と、アニメ調を狙いたい場合では、最適なモデルや設定が変わるということを意識する必要があります。

次に設定。

ステップ数やCFGスケール、サンプリング手法の選択は出力画像の完成度に直結します。

ここを理解せずに使ってしまうと、どれだけ優れたプロンプトを入力しても、望むような結果にならない可能性が高まります。

最後に出力解釈。

画像を見て

「思っていたのと違う」

と感じたとき、それがプロンプトの問題なのか、設定なのか、モデルの特性なのかを見極める眼が必要です。

中級者に求められるのは

「なぜその画像が生成されたのか?」

を逆算して理解するスキル。

この視点を持てば、次の活用ステップ(プロンプトの高度な使い方)にもスムーズに進めるはずです。

中級者向け活用法①:プロンプトの高度な使い方

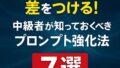

具体的なプロンプト設計のコツ

Stable Diffusionの実力を引き出すためには、プロンプトの設計精度が重要なカギとなります。

単にキーワードを並べただけでは、曖昧な画像や意図しない構図が生成されることもあります。

中級者が押さえるべきは、構造を意識したプロンプト設計です。

たとえば

「a girl in a forest, sunlight filtering through trees, ultra detailed, 4K, cinematic lighting」

といったように、対象・環境・ディテール・品質・雰囲気を順序立てて記述するのが効果的です。

さらに、修飾語の位置や種類によって、生成される絵の構図や彩度が変わる点にも注意が必要です。

これは、言語処理の優先度と関連しており、プロンプト内でどこに何を配置するかが絵の仕上がりを左右します。

同じキーワードを使っても、順番と粒度を調整するだけで全く異なる結果になる。

この感覚を養うことで、より精密な画像が安定して生成できるようになります。

否定プロンプト(Negative Prompt)を効果的に使うには?

中級者が次のステップに進む上で避けて通れないのが

「Negative Prompt(否定プロンプト)」の活用

です。

これは

「含めたくない要素」

を明示的に除外するためのテクニックで、画質や構図の安定化に欠かせません。

たとえば、生成画像に意図しない「歪んだ手」や「過剰な装飾」が出る場合、それを抑える言葉を否定プロンプトに入れることで、生成の精度を上げることが可能です。

注意すべき点は、否定ワードを並べすぎると出力の自由度が失われること。

画像の魅力を損なわずに不要な要素だけを除外するには、対象の頻出傾向とプロンプトのバランス感覚が求められます。

構文の例と注意点

具体的には

「ugly, blurry, deformed hands, extra limbs, bad anatomy」

などがよく使用される否定プロンプトです。

これを使うことで、人体の不自然な描写や画質の劣化を防ぎやすくなります。

ただし、あくまで画像の目的に応じた取捨選択が大切です。

人物主体のポートレートなら「lowres」や「poor lighting」を外す一方で、幻想的なアート系作品なら一部の歪みが「味」になることもあります。

否定プロンプトは万能ではなく、調整と実験を繰り返すことで最適化されるという点を忘れずに、設定していきましょう。

キーワード選定と表現の幅を広げるコツ

中級者になると、出力結果に対する要求も高まります。

そんなときに効いてくるのが、キーワード選定の引き出しを増やす工夫です。

たとえば、単に

「beautiful face」

と書くよりも

「symmetrical face, sharp jawline, high cheekbones, detailed eyes」

など、具体的かつ視覚的な語彙を選ぶことで精度が高まります。

この選定を助ける手段として、プロンプトライブラリや生成画像に使われたキーワードを逆引きするツールを活用するのもひとつの方法です。

また、英語特有のニュアンスや言い回しを研究することで、日本語では難しい細かい表現も可能になります。

大切なのは、思いつきのキーワードを重ねるのではなく、出したい絵に合った言葉を戦略的に選ぶこと。

言葉一つで画像は大きく変わる――その実感を積み重ねるほど、Stable Diffusionの表現力は開花していきます。

中級者向け活用法②:カスタムモデルの導入と活用

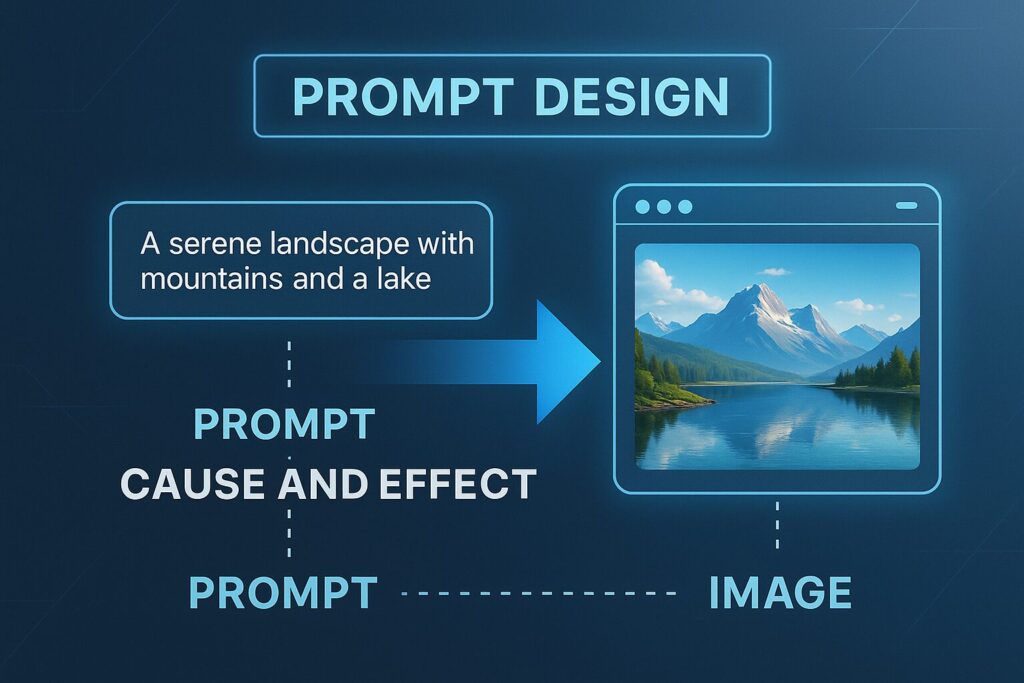

LoRA・ControlNetとは?導入前に知っておくべきこと

Stable Diffusionの中級者がさらに表現の幅を広げるには、「カスタムモデル」の活用が不可欠です。

中でも、LoRA(Low-Rank Adaptation)とControlNetは、特定のスタイルや構図を実現するうえで大きな武器になります。

LoRAは、既存のモデルに軽量な追加情報を適用する仕組みで、学習済みのモデルに対して新しいスタイルや表現を加えることができます。

これにより、ファイルサイズを大幅に増やさずに、アニメ調や絵画風など多彩な変化を実現できるのが特徴です。

一方、ControlNetは画像の構図やポーズ、ライン構成を意図通りに制御するためのツールです。

たとえば、下絵を元に構図だけを維持しつつ別スタイルで生成する場合や、手のポーズや背景構造を固定したい場面で活用されます。

ただし、これらのツールは高度な設定を伴うため、導入前には使用する環境や前提モデルの互換性をしっかり確認しておく必要があります。

導入手順の概要とよくあるトラブル

カスタムモデルの導入は、Stable Diffusion Web UI(AUTOMATIC1111)などのプラットフォームを前提に進めます。

基本的な流れとしては、対象モデルをダウンロードし、所定のフォルダに配置することで使用可能になります。

たとえば、LoRAの場合は

「/models/Lora」

に格納し、生成時にプロンプト内で<lora:モデル名:重み>のように指定します。

一方、ControlNetは拡張機能を追加し、画像ガイド付きでの生成を可能にするインターフェースが表示されるようになります。

このとき注意すべきは、対応するバージョンの不一致やモデルの誤配置です。

たとえば、SD1.5用のLoRAをSDXLに使おうとすると正常に動作しないなど、互換性の理解が浅いとエラーの原因になります。

動作しない・精度が落ちる原因と対処法

カスタムモデルの動作に不具合が出た場合、まず確認したいのがパスやファイル名の指定ミスです。

とくに英数字や記号の打ち間違いは、LoRAなどでよく見られる問題のひとつです。

また、精度が落ちる場合は「モデルの重み」や「組み合わせるプロンプトとの相性」に問題がある可能性があります。

重みを大きくしすぎると、画像が不自然になったり、逆に小さすぎると効果が出なかったりします。

さらに、ControlNetで構図が反映されない場合、読み込ませるガイド画像が適切に変換されていないケースも少なくありません。

このような場合は、付属のpreprocessorを変更するか、別の画像形式を試すことで改善が見込めます。

おすすめのモデル配布サイトと探し方

カスタムモデルを入手する際は、信頼性と更新頻度が鍵となります。

代表的なのが、CivitaiとHugging Faceです。前者は特にLoRAやスタイル特化モデルが充実しており、ユーザー評価やサンプル画像で選びやすい設計になっています。

一方で、精度の高さを重視する場合は、研究者や実績のある開発者が公開しているGitHubリポジトリや、Hugging Face内の公式アカウントが配布しているものが安心です。

モデルを探す際には、生成したいイメージに近い画像をベースに、「モデル名 + サンプル」や「LoRA + 表現スタイル」などで検索すると効率的です。

不明瞭な名前のモデルや、評価数が極端に少ないファイルは避けるのが、安全に導入するための基本的な姿勢です。

中級者向け活用法③:出力画像のクオリティを高める設定術

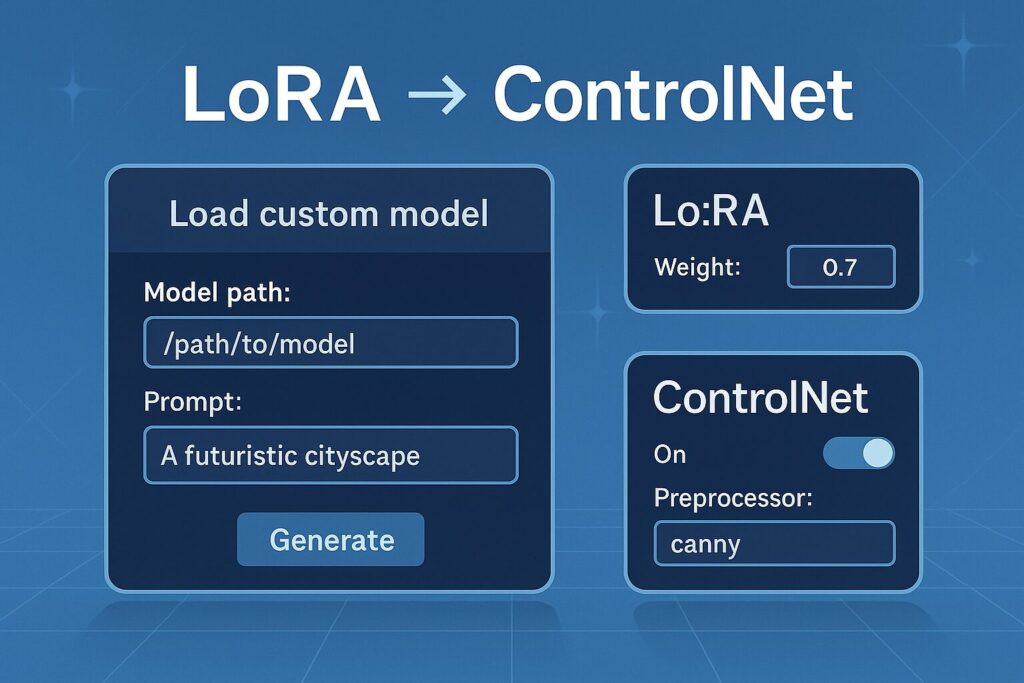

ステップ数・CFG値・解像度の調整が与える影響

Stable Diffusionの出力品質を左右する最も基本的な要素が、ステップ数・CFGスケール・解像度の3つです。

これらは単なる数字ではなく、生成結果の完成度に直結する重要なパラメータです。

ステップ数は、画像を仕上げるまでの反復処理の回数を表します。

数値が低いと生成が早くなる一方で、ディテールや構図が不安定になる傾向があります。

逆に高すぎると処理が重くなり、時間をかけても劇的な変化が得られないこともあるため、適正なバランスが求められます。

次にCFG値(Classifier Free Guidance)は、プロンプトに対する忠実度をコントロールする設定です。

数値が高いとキーワードに厳密に従いますが、構成の自由度が減り、絵の自然さが損なわれるリスクがあります。

一方で、低すぎると意図が伝わらず、全く異なるイメージが出てくることもあります。

解像度も無視できません。512×512は標準ですが、より高い解像度を指定すれば細部の描写が向上します。

ただし、高解像度での処理はVRAM消費も大きく、PCのスペックに左右される点を考慮しておく必要があります。

バッチ処理やリサイズ機能の活用ポイント

生成効率を高めながら、品質の高い画像を安定的に得るにはバッチ処理の活用が効果的です。

バッチサイズを大きく設定することで、複数パターンを一度に出力でき、偶発的な“当たり画像”に出会える確率が格段に上がります。

この手法は特に、構図や色合いを自動的に比較しながら、最も完成度の高い1枚を選びたいときに有効です。

また、異なる重みやNegative Promptを微調整した状態で一括生成することで、プロンプトの検証作業も効率化されます。

一方で、リサイズ機能も画像品質の最適化に活用できます。

Stable Diffusionでは、出力後にアップスケーリングを行うことで、低解像度の制限を超えた仕上がりを実現することが可能です。

ただし、リサイズ処理に使うアップスケーラの選定を誤ると、ノイズが強調されたりディテールがぼやけたりするので注意が必要です。

高解像度での自然な仕上がりを狙うなら、ESRGAN系や4x-Animeなど、用途に合わせたモデルを選ぶ視点も重要になります。

ポストプロセスで仕上げる画像編集のヒント

生成された画像に最後の一手間を加えることで、作品としての完成度が飛躍的に向上します。

ポストプロセスとは、Stable Diffusionの出力後に行う補正作業のこと。

色味の調整やコントラスト強調、フィルタの追加などが代表的です。

たとえば、生成直後の画像はややくすんだ印象になることがあります。

これを避けるには、画像編集ソフトやWebツールを使って色調整を行うだけでも、印象は大きく変わります。

特にSNSやポートフォリオで公開する場合、発色や明暗の微調整が効果的です。

また、目や髪のディテールを強調したい場合は、部分補正によってリアリティを加えるのも有効です。

これにより、構図そのままで印象を劇的に変えることができます。

さらに、AIノイズの残りやアーティファクトが目立つ場合には、ノイズ除去やシャープネス補正を軽くかけることで、「生成っぽさ」を消してナチュラルな雰囲気を演出できます。

ポストプロセスを制する者は、Stable Diffusionのクオリティを本物に引き上げる最後の仕上げ人ともいえるでしょう。

よくある疑問とその回答

どこまでが「中級者」なの?上級者との違いとは

Stable Diffusionにおける「中級者」とは、基本操作を超えて設定やモデルの選定にある程度慣れているユーザーを指します。

具体的には、プロンプトの工夫やNegative Promptの活用、LoRAやControlNetなどの導入に一度はチャレンジしているレベルといえるでしょう。

一方で、「上級者」と呼ばれる層は、生成だけでなくモデルの訓練やファインチューニングにまで踏み込んでいる場合が多く、PythonやCLIツールに精通しているケースもあります。

中級者の多くはWeb UIベースの操作に慣れており、生成品質を上げるためにパラメータやモデルの組み合わせを積極的に調整しています。

しかし、自作の学習モデルを開発する、ノードベースで処理を構築するなどの段階にはまだ至っていません。

つまり、Stable Diffusionを“使いこなす”中級者と、“構築する”上級者との間には技術的にも運用面でも明確なラインが存在するのです。

無料で使える拡張機能やツールはある?

Stable Diffusionはオープンソースで開発されているため、無料で使える便利なツールや拡張機能が非常に豊富です。

中級者にとってありがたいのは、AUTOMATIC1111版Web UIをはじめ、LoRA LoaderやControlNet Extensionといった有志が開発した拡張機能群です。

たとえば、画像の構図やポーズを意図通りに反映できるControlNetは、構成力の強化と失敗率の低下に直結する拡張です。

また、プロンプトの組み合わせや履歴を簡単に管理できるPrompt Generator系プラグインも、作業効率を格段に上げてくれる存在です。

加えて、アップスケーリングやノイズ除去といったポストプロセスを支援するツールも無料で提供されています。

特に、ESRGANやSwinIRといった高性能アップスケーラは、出力画像の品質を飛躍的に引き上げるポテンシャルを秘めています。

こうしたツールはGitHubやCivitai、Hugging Faceなどのプラットフォームから入手できるため、コストをかけずに機能拡張したい中級者にとっては、まさに宝庫といえるでしょう。

商用利用するには何を注意すべき?

Stable Diffusionで生成した画像を商用利用する際には、ライセンスや使用規約に関する確認が不可欠です。

まず、大前提として、Stable Diffusion自体はCreativeML Open RAIL-Mライセンスに準拠しており、商用利用が認められています。

ただし、使うモデルやLoRA、拡張機能によっては個別に商用利用を制限しているケースもあるため、導入時には必ずライセンス表記や規約欄を確認する必要があります。

たとえば、キャラクターを描写するLoRAの一部は、個人利用に限定されていたり、配布元のクレジット表記を義務付けていたりすることがあります。

このルールを無視すると、著作権や商標侵害に該当するリスクが生じかねません。

また、商用利用の範囲もあいまいになりがちです。

SNS投稿はOKでも、商品パッケージや販売用画像に使う場合は制限があるケースもあります。

この点を明確にするためには、配布元に問い合わせる、または公式文書をチェックすることが重要です。

収益を生むコンテンツにStable Diffusionを使うなら、ライセンスの理解が作品の価値と信頼性を守る鍵になります。

まとめ~Stable Diffusionをもっと深く活用するために~

本記事で紹介した3つの中級者向け活用法の再整理

Stable Diffusionを活用する中で、中級者が押さえておくべきポイントは明確です。

まず1つ目は、プロンプトの高度な設計術。

単語の並び方や構文に工夫を加えるだけで、出力される画像の質や方向性が劇的に変化します。

2つ目は、カスタムモデルの導入と応用。

LoRAやControlNetなどを上手に組み合わせることで、一歩先を行く独自スタイルの画像生成が可能になります。

そして、3つ目は、設定値の最適化によるクオリティの向上です。

ステップ数・CFG値・解像度を調整し、ポストプロセスまで見据えて手を加えることで、作品として通用する水準のビジュアルが安定して出力できるようになります。

この3つの柱をしっかり押さえれば、中級者としてのレベルアップは着実に進むでしょう。

次に挑戦すべきこと:上級者へのステップアップ

ここまでの内容をマスターした方が次に目指すべきは、Stable Diffusionを「使いこなす」から「創る」へと視点を広げることです。

具体的には、自分専用のLoRAをトレーニングする、独自のモデルを学習させる、CLI操作にチャレンジするなど、より深い技術的理解が求められる領域へと入っていきます。

特に最近では、画像生成の精度と一貫性を高めるためのノードベース構成や、スタイル一貫性のあるキャラクター生成に関する技術が注目されています。

これらに取り組むことで、商用レベルのアウトプットにも対応できるスキルが養われていきます。

また、倫理や著作権の理解も含めて、AI画像との向き合い方を再定義する視点も今後の成長に欠かせません。

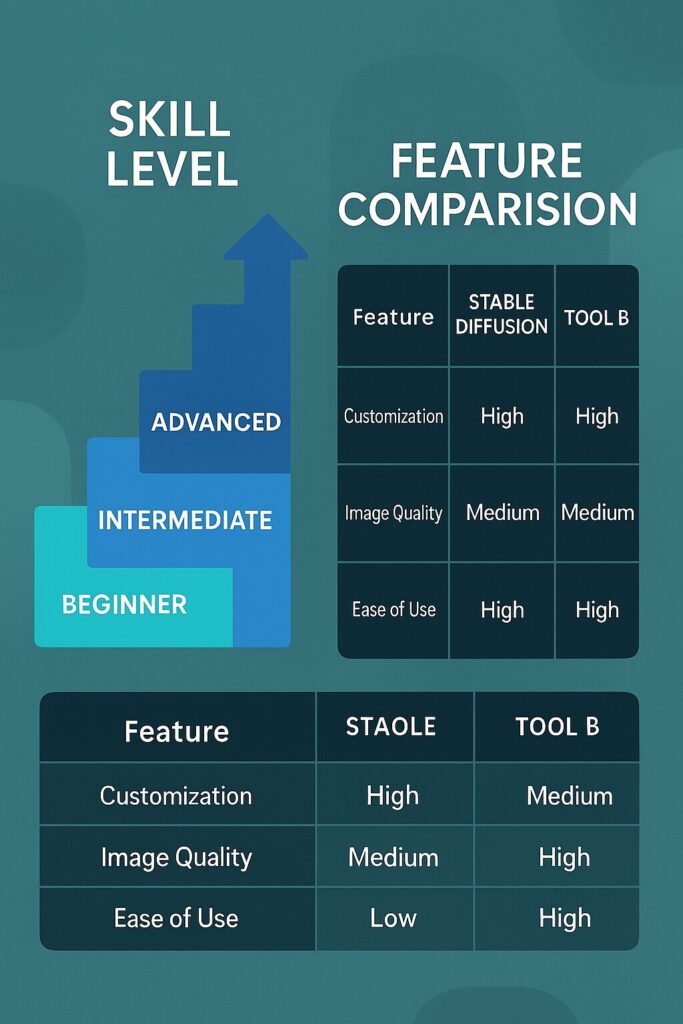

他のAI生成ツールと比較して分かる特徴

AI画像生成ツールには様々な種類がありますが、Stable Diffusionが持つ最大の強みは、カスタマイズ性の高さとオープン性にあります。

MidjourneyやDALL·Eのようなツールは、手軽さや自動補正が魅力ですが、自由度という面ではStable Diffusionの方が一歩リードしています。

特に中級者以上にとっては、プロンプトの精緻な調整やモデル自体の選択・変更が可能な点が制作の幅を大きく広げる鍵になります。

これにより、商用グラフィックやアート作品、個人ブランドのビジュアルにも対応できる強力な土台となります。

また、無料で使えるリソースが豊富なため、学習コストを抑えながらハイエンドな成果物を目指せる点も他ツールとは大きく異なる部分です。

今後も発展が続くStable Diffusionを深く理解し、正しく活用することで、AIクリエイションの新たな可能性がどこまでも広がっていくはずです。

最新情報はXで発信中!

リアルな声や速報は @ZeroAiFrontier でも毎日つぶやいています!